苹果传闻已久的智能眼镜Apple Glasses终于有可信的时间表。根据彭博社的报道,苹果为智能眼镜开发的专用芯片已进入关键阶段。这款基于 Apple Watch 芯片架构的定制化 SoC,通过移除图形渲染等冗余模块,将能效比提升至 iPhone 芯片的 1/3。其核心任务是处理多摄像头数据 —— 苹果计划在眼镜上搭载至少 4 枚传感器,包括两枚用于空间定位的 ToF 镜头和两枚环境光传感器,这使得设备能实时构建 3D 场景地图,精度达到毫米级。

一、预计发布时间

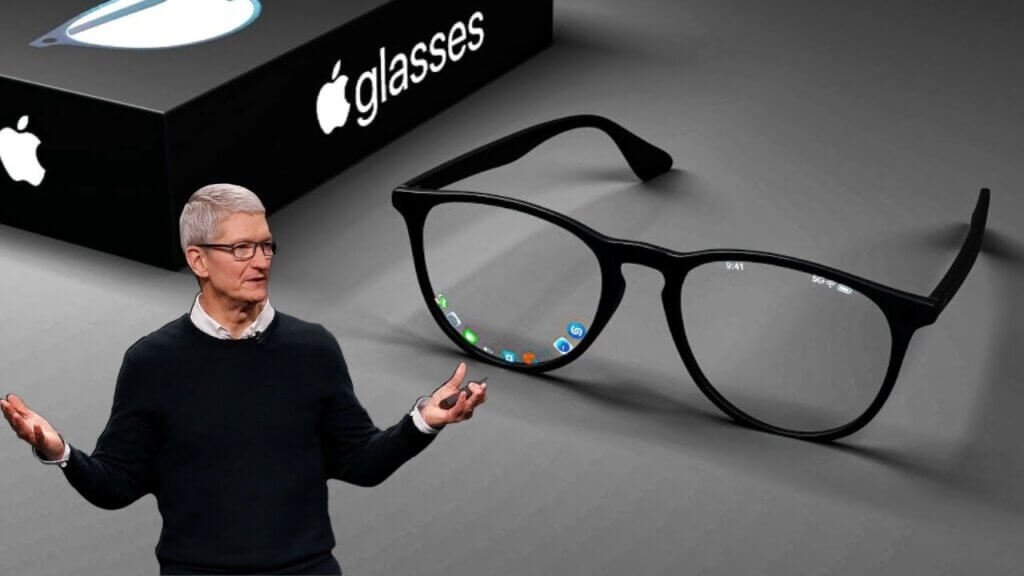

根据彭博社、The Verge 等权威媒体的交叉验证,苹果正以「两步走」策略推进 Apple Glasses 的商业化进程:非 AR 版本(代号 N401)预计 2026 年 Q4 率先亮相,直接对标 Meta Ray-Ban 眼镜的 329 美元定价,主打轻量化(48 克以内)和基础功能如拍照、实时翻译。而AR 版本(N301)计划于 2027 年下半年推出,采用分体式设计,外置算力模块通过毫米波技术实现 5 毫秒级低延迟数据传输,目标重量控制在 32 克。这一时间表与台积电 3nm 芯片量产计划(2026 年 Q3 试产)高度吻合,确保核心硬件供应的稳定性。

二、产品形态:从「时尚配饰」到「计算中枢」的进化

1. 非 AR 版本:低调的功能主义

该版本采用钛合金铰链和超轻碳纤维镜架,支持处方镜片更换,设计上延续苹果「科技 + 时尚」的基因,目标是成为像 Apple Watch 一样的日常穿戴设备。核心配置包括:

- 多传感器协同:至少 4 枚摄像头(含两枚 ToF 镜头),可实时构建毫米级精度的 3D 场景地图,支持空间定位和环境光自适应调节。

- 能效优化芯片:基于 Apple Watch 架构的定制 SoC,移除图形渲染模块,能效比达 iPhone 芯片的 1/3,确保单次续航 8 小时。

- 基础交互功能:集成 Siri 语音助手、实时翻译和健康监测(如心率、血氧),数据同步至 iPhone 和 Apple Watch。

2. AR 版本:分体式设计的颠覆性尝试

苹果采用「眼镜本体 + 外置算力模块」的分体方案:

- 显示技术突破:索尼与台积电合资企业提供的双 1080P Micro LED 屏幕,户外亮度达 5000 尼特,支持动态透光率调节,用户可在增强现实与真实世界间无缝切换。

- 交互革命:测试中的「光子手套」配件通过手指动作实现毫米级精度控制,配合骨传导 + 定向声场技术,可在公共场合实现私密通话。

- 健康监测创新:与 Rockley Photonics 联合开发的非侵入式血糖监测模块,通过泪液分析实时检测血糖水平,若通过 FDA 认证,将彻底改变糖尿病管理方式。

三、市场挑战:在 Meta 与技术之间寻找平衡

尽管苹果在硬件和生态上占据优势,但市场竞争不容小觑。Meta 的 Ray-Ban 智能眼镜已累计销售超 200 万台,其成功源于精准的定位 —— 轻量化、低价格和社交属性。苹果需要在技术领先性与市场接受度之间找到平衡点:例如,非 AR 版本需在拍照质量、语音交互响应速度等基础功能上超越 Meta,而 AR 版本则需解决应用生态不足的问题。

开发者生态建设已悄然启动。苹果秘密资助 Niantic 等 AR 开发商超 2 亿美元,要求首批应用必须支持空间持久化功能,即用户创建的 AR 内容可在物理空间中长期保存。这一策略旨在复制 iPhone 初期的 “杀手级应用” 效应,通过早期开发者锁定用户习惯。

四、未来展望:”空间计算” 战略的核心支点

对苹果而言,Apple Glasses 不仅是一款产品,更是其 “空间计算” 战略的核心支点。库克在内部会议上多次强调,AR 技术将像 iPhone 一样改变人们的生活方式,而 Apple Glasses 就是实现这一目标的载体。从技术路径看,苹果正通过 “眼镜 – 耳机 – 手表” 的组合构建全场景感知网络,这可能比 Meta 的 “元宇宙” 概念更贴近消费者需求。

行业观察家指出,Apple Glasses 的推出将加速智能眼镜市场的分化:高端市场聚焦 AR 体验,中端市场主打轻量化 AI 功能,低端市场则以基础可穿戴设备为主。苹果若能在 2027 年按时推出 AR 版本,极有可能复制 iPhone 在智能手机市场的统治地位 —— 但前提是解决显示技术、应用生态和隐私保护等关键问题。

在这场可穿戴设备的革命中,Apple Glasses 或许不是第一个吃螃蟹的产品,但凭借其强大的芯片研发能力、生态整合优势和对用户体验的极致追求,它很可能成为重新定义行业规则的 “终结者”。正如库克所言:”未来十年,我们将看到 AI 与可穿戴设备的结合,彻底改变人类与数字世界的交互方式。” 而 Apple Glasses,或许正是这一未来的钥匙。

评论列表 (0条):

加载更多评论 Loading...